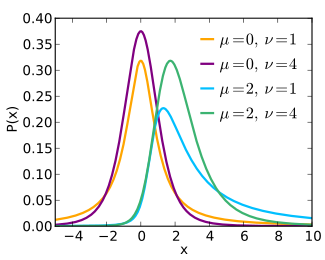

En Teoría de la probabilidad y Estadística, la distribución t no central generaliza la distribución t de Student mediante un parámetro de no centralidad. Así como en un contraste de hipótesis de igualdad de medias en una población normal, la distribución t de Student describe el estadístico de contraste cuando la hipótesis nula es cierta (igualdad de medias), la distribución t no central lo hace cuando la hipótesis nula es falsa; en consecuencia, es especialmente importante en el cálculo de la potencia estadística de un contraste. También se utiliza en la modelización robusta de datos.

Definición

Sea  una variable aleatoria normal estándar

una variable aleatoria normal estándar  y

y  una variable aleatoria χ² con

una variable aleatoria χ² con  grados de libertad que es independiente de

grados de libertad que es independiente de  . Se dice[1] que la variable aleatoria

. Se dice[1] que la variable aleatoria

tiene una distribución t no central con  grados de libertad y parámetro de no centralidad

grados de libertad y parámetro de no centralidad  ; se escribe

; se escribe  . Cuando

. Cuando  se obtiene una distribución

se obtiene una distribución  de Student ordinaria

de Student ordinaria  . Debe tenerse en cuenta que el parámetro de no centralidad puede ser negativo.

. Debe tenerse en cuenta que el parámetro de no centralidad puede ser negativo.

Comentario sobre los grados de libertad no enteros. El caso habitual de esta distribución es cuando el número de grados de libertad  es un número natural, pero tanto desde el punto de vista de las aplicaciones como de la teoría, es conveniente que esta distribución pueda tener cualquier número estrictamente positivo de grados de libertad,

es un número natural, pero tanto desde el punto de vista de las aplicaciones como de la teoría, es conveniente que esta distribución pueda tener cualquier número estrictamente positivo de grados de libertad,  . Esto es correcto gracias a que una distribución χ² cuadrado está bien definida para

. Esto es correcto gracias a que una distribución χ² cuadrado está bien definida para  .

.

Función de densidad

La función de densidad de la distribución t no central no tiene una expresión sencilla y veremos diversas formulaciones que aparecen en la literatura. Sea  .

.

Expresión integral [2]  Es interesante observar que cuando

Es interesante observar que cuando  es un número natural, esta fórmula puede escribirse en términos de la función

es un número natural, esta fórmula puede escribirse en términos de la función  [3]

[3]  donde

donde  Sobre la función

Sobre la función  consultar, por ejemplo, Jeffreys and Jeffreys. [4]

consultar, por ejemplo, Jeffreys and Jeffreys. [4]

Expresión en serie. [5]

Expresión mediante funciones especiales.

Utilizando la función cilíndrica parabólica  [6](ver la versión digital [7]),

[6](ver la versión digital [7]),

tenemos que [8] Mediante la función hipergeométrica confluente o función de Kummer

Mediante la función hipergeométrica confluente o función de Kummer  , también denotada por

, también denotada por  [9],

[9],  donde

donde

Expresión en términos de la función de distribución El software estadístico R y otros programas estadísticos utilizan la siguiente expresión para calcular la función de densidad [1]:

donde

donde  es la función de distribución de la distribución

es la función de distribución de la distribución  no central con

no central con  grados de libertad y parámetro de no centralidad

grados de libertad y parámetro de no centralidad  (véase el siguiente apartado).

(véase el siguiente apartado).

| Demostraciones |

| Fórmula (1) Escribimos  donde donde  , ,  , con , con  (distribución χ con (distribución χ con  grados de libertad), grados de libertad),  y y  independientes. Utilizando que si una variable aleatoria independientes. Utilizando que si una variable aleatoria  tiene función de densidad tiene función de densidad  , entonces la variable aleatoria , entonces la variable aleatoria  , con , con  , tiene función de densidad , tiene función de densidad  , tenemos que la función de densidad de , tenemos que la función de densidad de  es es  Dada la independencia entre Dada la independencia entre  y y  , la función de densidad conjunta del vector , la función de densidad conjunta del vector  es es  Consideremos la transformación Consideremos la transformación  específicamente específicamente  donde donde  . Esta función es biyectiva de clase . Esta función es biyectiva de clase  . La función inversa es . La función inversa es  con con  . El valor absoluto del determinante jacobiano de . El valor absoluto del determinante jacobiano de  es es  . Por tanto la densidad de . Por tanto la densidad de  (después de arreglar la expresión) es (después de arreglar la expresión) es  Entonces, para Entonces, para  , ,  Haciendo el cambio Haciendo el cambio  , llegamos a la expresión (1) , llegamos a la expresión (1)  Expresión en serie. Volvamos a la expresión (*), que equivale a  y descompongamos y descompongamos  en serie de potencias en la variable en serie de potencias en la variable  . A continuación se razona que puede intercambiarse la integral con el sumatorio y se llega a . A continuación se razona que puede intercambiarse la integral con el sumatorio y se llega a  Ahora se calcula cada integral mediante el cambio de variable Ahora se calcula cada integral mediante el cambio de variable  , con lo que obtenemos (2). , con lo que obtenemos (2). Expresiones en términos de funciones especiales. La fórmula (3) se deduce de la fórmula (1) utilizando la representación integral de la función cilíndrica parabólica  [10]: para [10]: para  , ,  La fórmula (4) se obtiene a partir de (3) mediante la relación entre las funciones cilíndricas parabólicas y las funciones hipergeométricas confluentes [11] [12] [13] La fórmula (4) se obtiene a partir de (3) mediante la relación entre las funciones cilíndricas parabólicas y las funciones hipergeométricas confluentes [11] [12] [13]  Expresión en términos de la función de distribución (5): véase el siguiente apartado.. Expresión en términos de la función de distribución (5): véase el siguiente apartado.. |

Función de distribución

La función de distribución de la distribución t no central con  grados de libertad y parámetro de no centralidad

grados de libertad y parámetro de no centralidad  se puede expresar como [14][15]

se puede expresar como [14][15]  donde

donde

es la función beta incompleta regularizada,

es la función beta incompleta regularizada,

y  es la función de distribución de la distribución normal estándar. Nótese que

es la función de distribución de la distribución normal estándar. Nótese que  sólo depende de

sólo depende de  y por tanto en (6), para

y por tanto en (6), para  es indistinto poner

es indistinto poner  o

o  .

.

| Demostración |

Esta fórmula se deduce a partir de la expresión en serie de la función de densidad (2). Empezaremos demostrando una fórmula intermedia que nos será de utilidad más adelante. Argumentando que la convergencia de la serie en (2) es uniforme en cualquier intervalo finito [16] , podemos integrar término a cabo; concretamente, para  , se obtiene , se obtiene  Ahora se utiliza la fórmula de duplicación de la función gamma: Ahora se utiliza la fórmula de duplicación de la función gamma:  y se obtiene y se obtiene  Por otro lado,  Así, Así,  Designemos la expresión de la derecha por Designemos la expresión de la derecha por  . . Para  , tenemos , tenemos donde hemos utilizado que donde hemos utilizado que  es simétrica respecto al 0 y que la función es simétrica respecto al 0 y que la función  que hemos calculado antes sólo depende de que hemos calculado antes sólo depende de  . . Finalmente, para obtener la expresión (7), el sumatorio de (8) se separa en dos, uno para los índices  pares y el otro para los impares. pares y el otro para los impares. |

| Demostración de la fórmula de la densidad en términos de la función de distribución |

La demostración consiste en calcular la diferencia  utilizando la fórmula (8). Fijemos utilizando la fórmula (8). Fijemos  ; el punto clave de la prueba es que en la expresión (8) de ; el punto clave de la prueba es que en la expresión (8) de  y de y de  , para cada término , para cada término  del sumatorio, el subíndice de la función gamma incompleta es el mismo . Concretamente, si definimos la función del sumatorio, el subíndice de la función gamma incompleta es el mismo . Concretamente, si definimos la función entonces, entonces,  A a partir de esa observación se aplica la fórmula [17] A a partir de esa observación se aplica la fórmula [17]  donde donde  es la función Beta, en cada una de las diferencias entre los sumandos del mismo índice es la función Beta, en cada una de las diferencias entre los sumandos del mismo índice  (ambas series son convergentes y las podemos restar término a término), de donde (ambas series son convergentes y las podemos restar término a término), de donde  Aplicando la fórmula de duplicación de la función beta y simplificando, juntando todos los términos del sumatorio, se obtiene  que multiplica la expresión de la derecha de (2), con lo que se demuestra (5 ) cuando que multiplica la expresión de la derecha de (2), con lo que se demuestra (5 ) cuando  . . Para  , por los cálculos efectuados, tenemos que , por los cálculos efectuados, tenemos que donde donde  designa la función de densidad de la distribución designa la función de densidad de la distribución  con con  grados de libertad y parámetro de no centralidad grados de libertad y parámetro de no centralidad  . Pero como se comprueba a partir de (1) o (2), . Pero como se comprueba a partir de (1) o (2),  |

Momentos

El momento de orden  de una distribución

de una distribución  no central es [18]

no central es [18]

![{\displaystyle {\mbox{E}}\left[T^{k}\right]={\begin{cases}{\Big (}{\dfrac {\nu }{2}}{\Big )}^{\frac {k}{2}}\,{\dfrac {\Gamma {\big (}{\frac {\nu -k}{2}}{\big )}}{\Gamma {\big (}{\frac {\nu }{2}}{\big )}}}\,e^{-\mu ^{2}/2}{\dfrac {d^{k}e^{\mu ^{2}/2}}{d\mu ^{k}}},&{\mbox{si }}k<\nu ,\\\\{\mbox{no existe}},&{\mbox{si }}k\geq \nu ,\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/90350c15fb85e849349aa8683bfd1794ff0a7973)

- donde

designa la derivada de orden k -ésimo de la función

designa la derivada de orden k -ésimo de la función  .

.

En particular, la media y la varianza son: ![{\displaystyle {\begin{aligned}{\mbox{E}}[T]&={\begin{cases}\mu \,{\sqrt {\dfrac {\nu }{2}}}\,{\dfrac {\Gamma {\Big (}{\frac {\nu -1}{2}}{\Big )}}{\Gamma {\Big (}{\frac {\nu }{2}}{\Big )}}},&{\mbox{si }}\nu >1,\\\\{\mbox{no existe}},&{\mbox{si }}\nu \leq 1,\\\end{cases}}\\\\{\mbox{Var}}(T)&={\begin{cases}{\dfrac {\nu (1+\mu ^{2})}{\nu -2}}-{\dfrac {\mu ^{2}\nu }{2}}\left({\dfrac {\Gamma {\Big (}{\frac {\nu -1}{2}}{\Big )}}{\Gamma {\Big (}{\frac {\nu }{2}}{\Big )}}}\right)^{2},&{\mbox{si }}\nu >2,\\\\{\mbox{no existe}},&{\mbox{si }}\nu \leq 2.\\\end{cases}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f41f8aeec4fd8bc65fb40864f98668f0d12df2c)

| Demostración |

Debido a la independencia entre el numerador i el denominador en la definición de la distribución  no central, a que una variable normal tiene momentos de todos los órdenes y que no central, a que una variable normal tiene momentos de todos los órdenes y que  , el cálculo de los momentos se reduce a , el cálculo de los momentos se reduce a ![{\displaystyle E[T^{k}]=\nu ^{k/2}E{\big [}V^{-k/2}{\big ]}\,E{\big [}(Z+\mu )^{k}{\big ]},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c9f73cc6a5085d7927ee7393210cb0de99523fec) pudiendo ser esta expresión finita o pudiendo ser esta expresión finita o  . . Por un lado, para la distribución normal estándar  tenemos la siguiente expresión: tenemos la siguiente expresión: ![{\displaystyle E{\big [}(Z+\mu )^{k}{\big ]}=e^{-\mu ^{2}/2}\,{\dfrac {d^{k}e^{\mu ^{2}/2}}{d\mu ^{k}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a8c6f94dbe0015aa22808723dde1e1b7b69be12) Por otra parte, debido a que Por otra parte, debido a que  , podemos calcular la siguiente integral para cualquier número natural , podemos calcular la siguiente integral para cualquier número natural  ![{\displaystyle E{\big [}V^{-k/2}{\big ]}={\frac {1}{2^{\nu /2}\Gamma (\nu /2)}}\int _{0}^{\infty }x^{-k/2}x^{(\nu /2)-1}e^{-x/2}\,dx={\frac {1}{2^{\nu /2}\Gamma (\nu /2)}}\int _{0}^{\infty }x^{(\nu -k)/2-1}e^{-x/2}\,dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d3f5ea9cd061398ee4d88f664e74eac72d66327e) Hacemos el cambio de variables Hacemos el cambio de variables  , y la integral de la derecha da , y la integral de la derecha da   , y , y  en caso contrario. en caso contrario. |

Aplicación al cálculo de la potencia del contraste t de Student

Véase Johnson and Welch [19]. Sea  una muestra de una población normal

una muestra de una población normal  , es decir, las variables aleatorias

, es decir, las variables aleatorias  son independientes y todas tienen distribución

son independientes y todas tienen distribución  . Fijado un número

. Fijado un número  . Queremos contrastar

. Queremos contrastar  En el contraste de Student, el estadístico de contraste es

En el contraste de Student, el estadístico de contraste es  donde

donde  és la media muestral y

és la media muestral y  es la varianza muestral (modificada):

es la varianza muestral (modificada):  Bajo la hipótesis nula

Bajo la hipótesis nula  ,

,  (véase la distribución

(véase la distribución  de Student). Fijado un nivel de significación

de Student). Fijado un nivel de significación  (habitualmente

(habitualmente  o

o  ), para determinar la región crítica calculamos el valor

), para determinar la región crítica calculamos el valor  tal que

tal que donde

donde  En este contexto, rechazamos

En este contexto, rechazamos  si

si  . Dado un valor

. Dado un valor  (por tanto, de la hipótesis alternativa), podemos calcular la potencia del test, es decir, la probabilidad de rechazar la hipótesis nula cuando es falsa, en este punto, de la siguiente manera: escribimos

(por tanto, de la hipótesis alternativa), podemos calcular la potencia del test, es decir, la probabilidad de rechazar la hipótesis nula cuando es falsa, en este punto, de la siguiente manera: escribimos En la expresión de la derecha,

En la expresión de la derecha,

- Si suponemos

, entonces

, entonces  .

. - Tenemos que

y por tanto

y por tanto  es una variable aleatoria con una distribución

es una variable aleatoria con una distribución  (véase la distribución χ²) dividida por sus grados de libertad.

(véase la distribución χ²) dividida por sus grados de libertad. - Las variables aleatorias de los puntos 1 y 2 son independientes (véase la distribución χ²) .

En consecuencia, si  , tenemos que

, tenemos que  . Por tanto, la potencia del test en el punto

. Por tanto, la potencia del test en el punto  será

será

Uso en intervalos de tolerancia

Los intervalos de tolerancia normales unilaterales tienen una solución exacta en términos de la media muestral y la varianza muestral basada en la distribución t no central [20]. Esto permite calcular un intervalo estadístico dentro del cual, con cierto nivel de confianza, se encuentra una proporción especificada de la población.

Referencias

- ↑ Johnson, Norman L.; Kotz, Samuel; Balakrishnan, Narayanaswamy (1995). Continuous univariate distributions. 2 (2. ed edición). Wiley. p. 508. ISBN 978-0-471-58494-0.

|fechaacceso= requiere |url= (ayuda) - ↑ Scharf, Louis. Statistical signal processing: detección, estimación, y time series 0 (transferred to digital print on demand 2002; reprinted with corrections July, 1991 edición). p. 177.

- ↑ HOGBEN, D.; PINKHAM, R. S.; WILK, M. B. (1961). «The moments of the non-central t-distribution». Biometrika 48 (3-4): 465-468. ISSN 0006-3444. doi:10.1093/biomet/48.3-4.465. Consultado el 18 de enero de 2024.

- ↑ Jeffreys, Harold; Jeffreys, Bertha (2001). «Section 23.081». Methods of mathematical physics. Cambridge mathematical library (3. ed.; 1. paperback ed., reprinted 2001 edición). Cambridge Univ. Press. ISBN 978-0-521-66402-8.

|fechaacceso= requiere |url= (ayuda) - ↑ Craig, Cecil C. (1941-06). «Note on the Distribution of Non-Central $t$ with an Application». The Annals of Mathematical Statistics 12 (2): 224-228. ISSN 0003-4851. doi:10.1214/aoms/1177731752. Consultado el 18 de enero de 2024.

- ↑ National Institute of Standards and Technology (2010). Olver, Frank W. J., ed. NIST handbook of mathematical functions. Cambridge University Press. ISBN 978-0-521-14063-8.

|fechaacceso= requiere |url= (ayuda) - ↑ «12.5.1. NIST Handbook of Mathematical Functions. DLMF: §12.5 Integral Representations ‣ Properties ‣ Chapter 12 Parabolic Cylinder Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ Gil, Amparo; Segura, Javier; Temme, Nico M. (2023-10). «New asymptotic representations of the noncentral t ‐distribution». Studies in Applied Mathematics (en inglés) 151 (3): 857-882. Fórmula 2.12. ISSN 0022-2526. doi:10.1111/sapm.12609. Consultado el 18 de enero de 2024.

- ↑ «NIST Handbook of Mathematical Functions. DLMF: §13.1 Special Notation ‣ Notation ‣ Chapter 13 Confluent Hypergeometric Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ «12.5.1. NIST Handbook of Mathematical Functions. DLMF: §12.5 Integral Representations ‣ Properties ‣ Chapter 12 Parabolic Cylinder Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ «12.4.1. NIST handbook of mathematical functions. DLMF: §12.4 Power-Series Expansions ‣ Properties ‣ Chapter 12 Parabolic Cylinder Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ «12.7.12, 12.7.13. NIST handbook of mathematical functions. DLMF: §12.7 Relations to Other Functions ‣ Properties ‣ Chapter 12 Parabolic Cylinder Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ «12.2.6, 12.2.7. NIST handbook of mathematical functions. DLMF: §12.2 Differential Equations ‣ Properties ‣ Chapter 12 Parabolic Cylinder Functions». dlmf.nist.gov. Consultado el 18 de enero de 2024.

- ↑ Lenth, Russell V. (1989). «Algorithm AS 243: Cumulative Distribution Function of the Non-Central t Distribution». Journal of the Royal Statistical Society. Series C (Applied Statistics) 38 (1): 185-189. ISSN 0035-9254. doi:10.2307/2347693. Consultado el 19 de enero de 2024.

- ↑ Gil, Amparo; Segura, Javier; Temme, Nico M. (2023-10). «New asymptotic representations of the noncentral t ‐distribution». Studies in Applied Mathematics (en inglés) 151 (3): 857-882, fórmulas (1.1) y (1.2). ISSN 0022-2526. doi:10.1111/sapm.12609. Consultado el 19 de enero de 2024.

- ↑ Craig, Cecil C. (1941). «Note on the Distribution of Non-Central t with an Application». The Annals of Mathematical Statistics 12 (2): 224-228. ISSN 0003-4851. Consultado el 19 de enero de 2024.

- ↑ Temme, Nico M. (1996). Special functions: an introduction to the classical functions of mathematical physics. A Wiley interscience publication. Wiley. p. 289, fórmula 11.3. ISBN 978-0-471-11313-3.

|fechaacceso= requiere |url= (ayuda) - ↑ Hogben, D; Pinkham, RS; Wilk, MB (1961). «The momentos de la no-central t-distribution». Biometrika 48 (3–4): 465-468. JSTOR 2332772. doi:10.1093/biomet/48.3-4.465. hdl:2027/coo.31924001119068.

- ↑ Johnson, N. L.; Welch, B. L. (1940). «Applications of the Non-Central t-Distribution». Biometrika 31 (3/4): 362-389. ISSN 0006-3444. doi:10.2307/2332616. Consultado el 19 de enero de 2024.

- ↑ Owen, D. B. (1968). «A Survey of Properties and Applications of the Noncentral t-Distribution». Technometrics 10 (3): 445-478. ISSN 0040-1706. doi:10.2307/1267101. Consultado el 19 de enero de 2024.

Datos: Q6960434

Datos: Q6960434

Datos: Q6960434

Datos: Q6960434

![{\displaystyle {\mbox{E}}\left[T^{k}\right]={\begin{cases}{\Big (}{\dfrac {\nu }{2}}{\Big )}^{\frac {k}{2}}\,{\dfrac {\Gamma {\big (}{\frac {\nu -k}{2}}{\big )}}{\Gamma {\big (}{\frac {\nu }{2}}{\big )}}}\,e^{-\mu ^{2}/2}{\dfrac {d^{k}e^{\mu ^{2}/2}}{d\mu ^{k}}},&{\mbox{si }}k<\nu ,\\\\{\mbox{no existe}},&{\mbox{si }}k\geq \nu ,\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/90350c15fb85e849349aa8683bfd1794ff0a7973)

![{\displaystyle {\begin{aligned}{\mbox{E}}[T]&={\begin{cases}\mu \,{\sqrt {\dfrac {\nu }{2}}}\,{\dfrac {\Gamma {\Big (}{\frac {\nu -1}{2}}{\Big )}}{\Gamma {\Big (}{\frac {\nu }{2}}{\Big )}}},&{\mbox{si }}\nu >1,\\\\{\mbox{no existe}},&{\mbox{si }}\nu \leq 1,\\\end{cases}}\\\\{\mbox{Var}}(T)&={\begin{cases}{\dfrac {\nu (1+\mu ^{2})}{\nu -2}}-{\dfrac {\mu ^{2}\nu }{2}}\left({\dfrac {\Gamma {\Big (}{\frac {\nu -1}{2}}{\Big )}}{\Gamma {\Big (}{\frac {\nu }{2}}{\Big )}}}\right)^{2},&{\mbox{si }}\nu >2,\\\\{\mbox{no existe}},&{\mbox{si }}\nu \leq 2.\\\end{cases}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f41f8aeec4fd8bc65fb40864f98668f0d12df2c)

![{\displaystyle E[T^{k}]=\nu ^{k/2}E{\big [}V^{-k/2}{\big ]}\,E{\big [}(Z+\mu )^{k}{\big ]},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c9f73cc6a5085d7927ee7393210cb0de99523fec)

![{\displaystyle E{\big [}(Z+\mu )^{k}{\big ]}=e^{-\mu ^{2}/2}\,{\dfrac {d^{k}e^{\mu ^{2}/2}}{d\mu ^{k}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a8c6f94dbe0015aa22808723dde1e1b7b69be12)

![{\displaystyle E{\big [}V^{-k/2}{\big ]}={\frac {1}{2^{\nu /2}\Gamma (\nu /2)}}\int _{0}^{\infty }x^{-k/2}x^{(\nu /2)-1}e^{-x/2}\,dx={\frac {1}{2^{\nu /2}\Gamma (\nu /2)}}\int _{0}^{\infty }x^{(\nu -k)/2-1}e^{-x/2}\,dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d3f5ea9cd061398ee4d88f664e74eac72d66327e)